こんにちは。LINE PlusのLINE AI LABでLLMエージェント関連サービスの開発を担当しているSumin Shinです。

私は、7月に東京で開催されたTech-Verse 2025に、現地を取材する「LINE DEVリポーターズ」として参加し、会場でLINEヤフーのさまざまな技術成果を直接体験できる機会を得ました。

今回のTech-VerseはAIがメインテーマの一つとして選定され、さまざまなサービスへの適用事例を交えたAI関連の発表が数多くありました。実務者として共感できる内容も多く、「ここで得た知識を自分の業務にどう活かせるか?」あるいは「これをもとに、どのような新しいサービスを開発できるだろうか?」と自分に問いかける時間となりました。

この記事では、発表内容を詳しく紹介するというよりも、実務者の視点で特に印象に残った瞬間を中心にお届けしたいと思います。Tech-Verse 2025の公式サイトではアーカイブ動画と発表資料を公開していますので、Tech-Verseを見逃した方はぜひご覧ください!

会場に向かう道

当日の朝、私は新宿駅近くのホテルを出発し、東京メトロに乗ってLINEヤフー株式会社(以下LINEヤフー)の本社に向かいました。リモートワークに慣れている私にとっては、久しぶりのオフィス出社でした。東京の通勤電車は、ソウルの地下鉄9号線の通勤ラッシュを思い出すほど混雑していて、「ああ、この街も通勤は楽じゃないな」と思いました。想像とは違う現実を実感した瞬間で、ほんの少しの間でしたが、本当に東京の会社員になった気分を味わえました。

Tech-Verseが行われた会場は、LINEヤフーが入居している東京ガーデンテラス紀尾井町の4階にあり、かなり広いスペースでさまざまなセッションが並行して行われました。紀尾井町のオフィスを訪れるのは初めてで、会社のオフィス内ではありませんでしたが、カンファレンスホールの入り口に到着したとき、ワクワクするよ��うな気分になりました。やっと会場にたどり着き、エアコンの涼しい風とともに抱いた第一印象が今でも鮮明に残っています。

会場の受付で名札を受け取って、中に入るとMain Room A、B、C、DとSeminar Room A、Bの合計6つのルームがありました。各ルームには、AIやSecurity、Server Sideなどのテーマが設定されており、そのテーマに関連するセッションが連続して行われる形式でした。私は主にAIセッションが行われたMain Room Aで過ごしました。

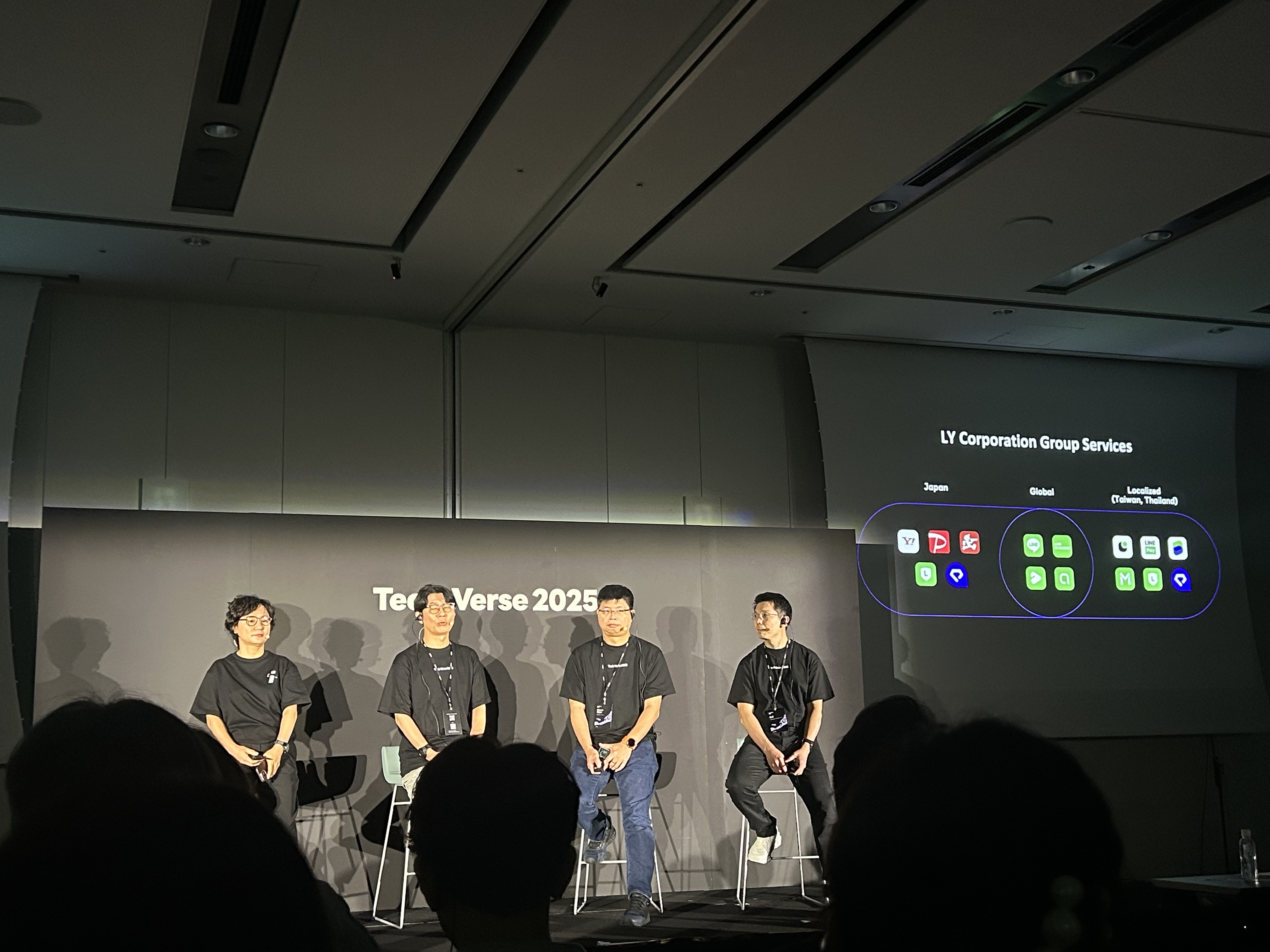

Keynoteの開始前に、多くの参加者がKeynoteの会場を埋め尽くす様子を見て、緊張感と期待感を同時に覚えました。Keynoteでは、LINE株式会社とヤフー株式会社の合併により必要になったプラットフォーム統合、ならびに今後のLINEヤフーのAI戦略および主なAI活用事例が紹介されました。その後のセッションの方向性が見える、予告編のような時間でした。

Tech-Verse DAY 1 - RAGからMCPまで、LINEヤフーのAI技術の底力を垣間見る

DAY1のKeynoteの後、Main Room Aでは、最近のAI業界でよく言及されるキーワードであるMCP(Model Context Protocol)やRAG(Retrieval-Augmented Generation)、エージェントなどをサービスに導入した事例を紹介するセッションが中心となりました。技術トレンドそのものよりも、「どのように導入し、どのようなハードルを乗り越えたか」に焦点を当てた発表が多く、より集中して聞くことができました。

その中で最も印象に残ったセッションは、AIとともに進化するエンジニアリングというタイトルで行われた「Ark Developer」に関する発表でした。LINEヤフーではArk Developerという名前で、社内向けに開発業務やプロセスに特化したAIソリューションを提供しています。RAGベースのコードアシスタントを構築し、コードの自動補完、レビューとセキュリティチェック、コメントとドキュメントの自動生成、テストコードの作成などをサポートしています。特に印象的だったのは、社内ドキュメントをストリーミング形式でリアルタイムに参照し、コードのコンテキストに沿ったサポートを提供する方法です。さらに、GitHubと連携してプルリクエストの作成まで行うデモも披露されました。このコードアシスタントが関連するコードを参照する際、単にコードベース全体を個別のドキュメントとして扱うのではなく、ディレクトリ構造をグラフのようにモデル化し、グラフ分析(graph analysis)を行う点も非常に興味深いものでした。

発表を聞いて、本当にAIが開発サイクル全体に深く関わっていると感じ、自然と「私たちのチームでもこのようなツールを導入して活用できるだろうか?」と思いました。発表が終わった後、隣に座っていた新人開発者に「これ、実際に使っていますか?」と聞いたところ、「Copilotよりも体感が良い」と答えてくれたのが印象に残りました。

もう一つ印象に残ったセッションは、AIが生成した画像の品質を測定する方法という発表でした。最近のAI技術は主にLLMとエージェント中心に流れていますが、その中でコンピュータービジョンの分野で活発に技術を研究し、サービスへ適用しているチームがあることが興味深かったです。特に、品質基準が主観的になりがちな画像生成技術の特性を補うために、評価方法を精緻にしようとする試みが、実務者の視点から見て印象的でした。

このセッションでは、3種類の画像生成モデルの結果を評価するさまざまな方法が紹介されました。具体的には、FID(Fréchet Inception Distance)やIS(Inception Score)といった画像分布に基づく従来の評価に加え、LAIONのAesthetic Scoreのような美的基準、LLMベースの評価であるCLIP-IQAやQ-Align、ビデオ言語モデルを活用したVQA(Visual Question Answering)ベースの質疑応答方式などが挙げられました。正解が存在しない生成画像の品質をどのように多角的に分析できるかについて、幅広く説明していただきました。

私はこの発表を聞いて、LINEヤフーで画像翻訳モデルやインペインティングモデルが実際にサービスとして運用されていることを初めて知りました。特に、画像を翻訳した後に元のテキストの形状や配置まで自然に復元する作業は、単なるOCR(Optical Character Recognition、光学文字認識技術)や翻訳ではなく、レイアウトや構造まで新たに生成する必要がある複雑な課題であり、その技術的難度が高いことを実感しました。

また、画像生成の結果をどのように評価し、改善していくかという悩みは、生成AI技術が実際のサービスに適用されている現時点で非常に現実的で重要な課題です。だからこそ、発表の内容がより深く心に響きました。私が最近担当しているLLMベースのプロジェクトも、明確な正解があるというよりは「より良い回答」を探す方向性に近いため、品質をどのように定量的に評価し、改善するかが鍵となっています。このセッションを通じて、生成AI全般において、単に技術を実装するだけでなく、「評価」と「検証」こそが品質につながるということを改めて実感しました。

休憩時間の記録

一日中、発表を聞くだけのイベントだと思っていましたが、Tech-Verseは想像以上のものでした。会場にはコミュニケーションスペースが別途設けられており、そこで数人ずつ集まって打ち合わせをしたり、談笑したりする姿が見られました。また、「プロダクトストリート」という名称のポスターセッションも行われました。2日間にわたって異なるポスターセッションが行われ、退屈する暇がありませんでした。

イベントで提供された軽食や食事、そしてコーヒーも忘れられません。1日目は紀尾井町のビル内にあるレストランで昼食を済ませ、2日目はお弁当が用意されていました。すき焼き弁当をおいしくいただきながら、日本に出張していることを実感しました。

セッションの合間には軽食も提供され、心身ともに満たされ、ゆったりとした雰囲気の中でイベントを楽しむことができました。さらに、2日間ともバリスタが現場で直接淹れてくれるコーヒーが用意されており、香りも味も良く、いつも長い行列ができていました。軽食も丁寧に用意されており、残っているのを見つけると、ついもう一つ手に取ってしまうほどおいしかったです。

また、印象に残っているのは、発表が終わった後に発表者が会場の外に立っていて、直接質問できた点です。私も発表を聞いていて気になったことを発表者に質問でき、短い時間でも直接会話を交わすことで、発表内容への理解がさらに深まったように思います。

面白かった瞬間もありました。Keynoteの後の最初のセッションでは、周りの人とペアを組んで挨拶や会話をする時間が設けられていました。1日目には隣に座っていた新人開発者と自然に挨拶を交わし、2日目には台湾からのAIタスクフォースチームといろいろな話をしました。話しているうちに、そのチームがArk Developerの一部を開発したと聞いて驚きました。さらに面白かったのは、発表が終わった後、発表者に質問しに行くたびに、偶然ですがそのチームと何度も顔を合わせたことです。

ほかにもエピソードがありますが、英語が苦手な発表者に質問しようとしたら、台湾のAIタスクフォースチームの一人が急きょ、日本語↔英語、日本語↔中国語の通訳を買��って出て、周りの参加者から期待を一身に受けることになりました。最後には、発表者よりもその方の言葉を待ってしまうほどでした。「本格的に交流しているんだな!」と思いました。予想外の出来事のおかげで、長く記憶に残りそうな瞬間でした。

Tech-Verse DAY 2 - AIを活用したサービス企画の事例

DAY2では、主にLLMや生成AIサービスを活用した具体的なサービス事例に関する発表が続きました。その中でも特に印象に残ったのは、"LINE PLANET" and AI: Conversations with AIというタイトルで、音声ベースのAIエージェントのための技術スタックと実際の事例を紹介するセッションでした。

この発表では、STT(Speech-to-Text) → LLM → TTS(Text-to-Speech、音声合成)という構造を中心に、その過程で発生するノイズやエコー、割り込み制御などの問題をどのように解決したかを説明していただきました。例えば、ユーザーの発話終了を判断するターン検出(turn detection)やマイク環境による音響エコー除去(acoustic echo cancellation)、ネットワーク遅延を最小化するための対策などが紹介されました。単なるパイプラインではなく、自然な会話を実現するために、さまざまな技術を有機的に組み合わせて設計している点が印象的でした。

この発表を聞いて、音声AIが単に入力と出力をつなぐ構造ではなく、まるで人間との会話のような自然さを追求する技術の総体であるという認識がより明確になりました。特に、リアルタイム性と自然さを両立させるための細かな設計要素は、実際に実装してみないとわ��からない技術的な難しさがあると感じました。また、私もこのような複雑な条件を満たすシステムを構成してみたいという、挑戦への意欲が湧きました。

音声AI以外にも、LINEヤフーで実際にAIを活用している事例が、発表セッションやポスターセッションで多数紹介されました。私はLINEヤフーに所属していますが、普段接する機会が少ないサービスについては、これまであまり詳しくありませんでした。映画レビューや広告の自動化、ショッピング、検索ベースの旅行先レコメンドなど、本当にさまざまな分野にAIが深く浸透していることを新たに知ることができました。.

社内向けのセッションもあったため、具体的に紹介することはできませんが、準備されていたセッションはタイトルと発表の流れを見るだけでも、AIが幅広く活用されていることが分かりました。何よりも繰り返し強調されていた「AIのための技術ではなく、サービスのためのAI」というメッセージが印象的でした。技術そのものよりもユーザー体験と実質的な価値を優先する姿勢に多くのことを考えさせられました。

Tech-Verseの後の懇親会まで

毎日、イベント終了後には懇親会がありました。日本の有名シェフが料理を振る舞ってくださり、おいしい料理をいただきながら、ほかのチームの方々と楽しく交流しました。集合写真も撮り、Tech-Verseの最後の瞬間まで余すとこ��ろなく満喫しました。

Tech-Verse 2025を振り返って

Tech-Verseを体験して最も感じたのは、みんながそれぞれの立場で本当にさまざまな課題をAIで解決していること、そして単に技術だけでなく、サービス・運用・コミュニケーション全体をつなげながらハードルを乗り越えていることでした。発表ごとに扱っている課題もアプローチ方法もさまざまでしたが、それぞれの立場でそれぞれの課題に取り組んでいるという共通点が印象的でした。

私はLINEヤフーのエンジニアですが、今回のイベントを通じて、普段接する機会が少ないサービスでも、コメントのモデレーション、ショッピング体験の改善、画像生成、広告の自動化など、さまざまな分野ですでにAIが導入されていることを初めて知りました。

ひとつひとつの技術に感銘を受けましたが、それ以上に印象的だったのは、その技術を実際に現場に活かし、共有しようとする人々の姿勢でした。同じ業界、さらには同じ会社で働いていても、他��のチームの業務の裏側をここまで深く知る機会はなかなかありません。発表を聞きながら多くの刺激を受け、私ももっと頑張りたいという気持ちが自然と湧いてきました。

今回のTech-Verseで多くのインスピレーションを得て、もっと学び、つながり、成長したいという思いが強まりました。次回のTech-Verseが開催される際には、私も登壇者としてプロジェクトを紹介できることを願っています。