들어가며

최근 몇 년 사이 인공 지능은 눈부신 발전을 거듭하고 있습니다. 대규모 언어 모델은 인간 수준의 언어 생성 능력을 갖췄고, 멀티모달 모델은 텍스트와 이미지를 넘나들며 추론하며, 특정 분야에서는 전문가에 필적하는 성능을 보이고 있습니다.

이렇게 고도화된 AI가 우리의 일상과 사회 속으로 깊숙이 스며들면서 '단순히 정확도가 높고 빠른 AI만으로 충분할까'라는 의문이 생기고 있습니다. 인간이 이해하지 못하는 의사결정, 사회적 맥락을 무시한 설계, 책임이 불분명한 자동화는 오히려 위험 요소로 작용할 수 있기 때문입니다. 이런 맥락에서 사람 중심의 AI, 다시 말해 인간의 능력을 강화하고, 인간과 협력하며, 인간의 책임과 윤리를 존중하도록 방향을 설정해야 한다는 목소리가 높아지고 있습니다.

지난 3월 이탈리아 칼리아리에서 열린 IUI(Intelligent User Interfaces) 2025 학회는 이러한 문제 의식을 공유하고 논의하는 자리였습니다. IUI는 인공 지능과 인간-컴퓨터 상호작용(human-computer interaction, 이하 HCI)의 접점에 선 학회로, 단순한 성능 경쟁을 넘어 인간을 중심에 둔 인터페이스와 시스템 설계를 지향하고 있습니다. 올해 학회에서는 여러 발표자들이 각자의 관점에서 'AI의 지속가능성'이라는 주제를 다뤘고, 이를 통해 학계와 산업 전반이 앞으로 지향해야 할 방향을 읽을 수 있었습니다.

저 또한 논문을 발표하기 위해 이번 학회에 참여하면서 다양한 세션에 참여해 여러 연구자들의 문제 의식과 해법을 들을 수 ��있었습니다. 그중에서도 특히 기억에 남은 발표는 알브레히트 슈미트(Albrecht Schmidt)와 베라 리아오(Q. Vera Liao), 제리 앨런 페일스(Jerry Alan Fails)의 세션이었습니다. 이들은 AI 활용과 관련해 중요한 화두들을 던졌는데요. 이번 글에서는 제가 각 발표를 들으며 얻은 인사이트를 바탕으로 발표의 핵심 내용을 요약하고 제 생각을 정리해 보려고 합니다.

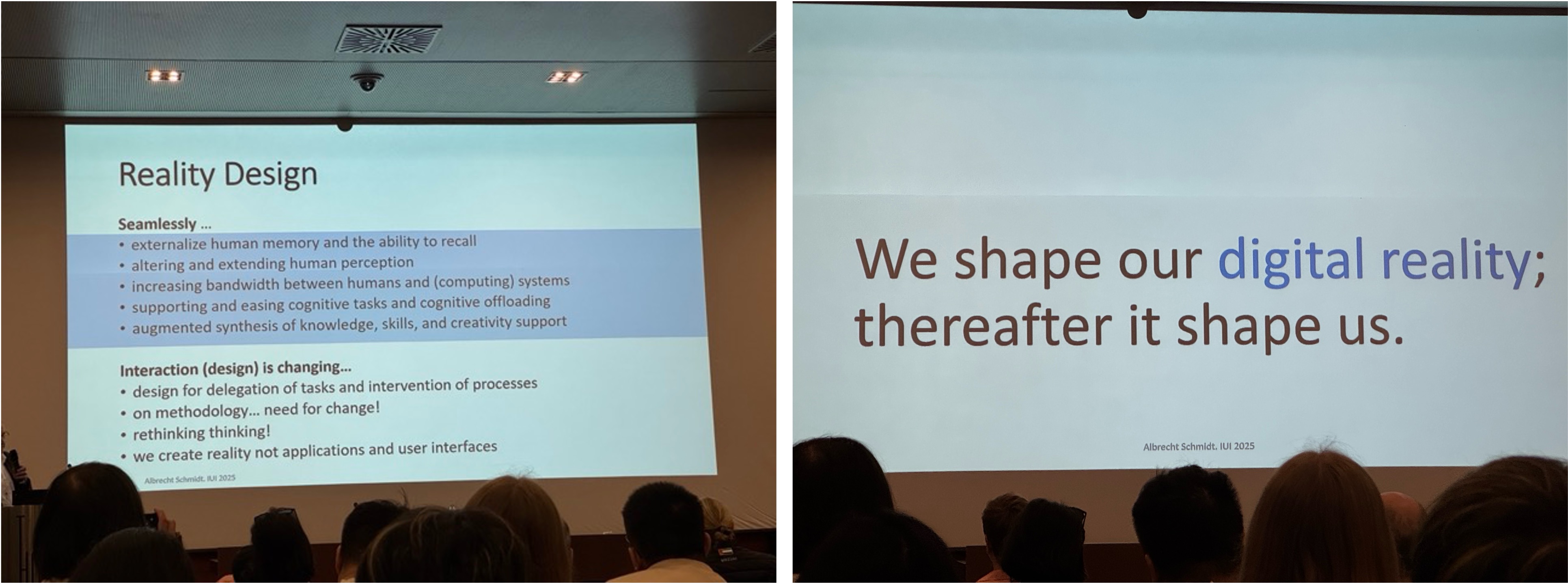

Reality Design: Shaping Experiences Beyond Interfaces through Human-Centered AI, Albrecht Schmidt

첫 번째로 소개할 발표는 알브레히트 슈미트 교수의 키노트였습니다. 슈미트 교수는 오랫동안 인간 중심 인터랙션과 증강 기술을 연구해 온 학자로, 이번 발표에서는 '리얼리티 디자인(Reality Design)'이라는 개념을 중심으로 인간과 AI의 관계를 재조명했습니다.

슈미트 교수의 주장은 명료했습니다. 지금까지의 HCI 연구가 주로 화면과 장치라는 좁은 틀 안에서 인터페이스를 다뤘다면, 이제는 현실 자체를 설계 대상으로 삼아야 한다는 것입니다. AI와 센서, 웨어러블 기기, 확장 현실(XR) 등의 기술이 일상에 통합되면서 인간의 지각과 인지, 기억 자체가 기술과 연결돼 인간의 능력이 증강(augmented)될 수 있다고 했습니다. 슈미트 교수는 이를 '리얼리티 디자인'이라고 명명하면서 인간 경험 전체를 디자인 대상으로 삼아야 할 필요가 있다고 강조했습니다.

발표에서는 인간의 능력이 증강된 구체적인 사례들도 소개됐습니다. 예를 들어 기억 확장 연구에서는 개인이 경험한 사건이나 대화를 AI가 자동으로 기록해 놓았다가 필요할 때 불러와 재구성할 수 있는 시스템을 실험한 사례가 소개됐습니다. 상담이나 교육, 연구 등의 분야에서 인간이 놓치기 쉬운 부분을 보완하고 관련 내용을 더 풍부하게 이해할 수 있게 만들고 있다고 합니다. 감각 증강 사례에서는 현실의 특정 동작을 슬로 모션으로 재현해 관찰력을 높이거나, 특정 음성을 선택적으로 청취할 수 있도록 해 사용자의 지각 능력을 강화하는 기술이 소개됐습니다. 또한 AI가 인간의 인지 능력 수준에 맞춰 작업 난이도를 조정해 주는 방식을 보여주기 위한 레고 블록 실험도 시연됐습니다. 이 실험은 협력적 지능이 어떻게 설계될 수 있는지 잘 보여줬습니다.

슈미트 교수는 발표에서 단순히 기술로 어떤 것이 가능한지 나열하며 가능성을 보여주는 것에서 그치지 않고, 기술이 인간의 사고와 학습 의지를 약화시키지 않도록 주의해야 한다는 점도 지적했습니다. 예를 들어 자동화된 기억 확장 장치가 지나치게 발달하면 인간은 스스로 기억하거나 학습하려는 동기를 잃을 수 있습니다. 슈미트 교수는 고대 철학자인 소크라테스가 글쓰기의 발명을 비판하면서 말했던 “글쓰기는 망각을 낳는다”라는 경구를 인용하며, 새로운 기술이 인간의 인지 능력을 대체할 때 발생할 수 있는 위험을 경고했습니다.

발표 마지막에는 'We shape our reality; thereafter it shapes us'라는 문장이 공유됐습니다. 이 문장은 기술과 인간의 관계가 일방향이 아니라 순환적이라는 점을 환기시켰습니다.

저를 포함한 청중들은 실험 사례에 흥미를 느꼈고, 발표에서 제기된 철학적 질문에 공감했습니다. 단순히 '새로운 기술을 어떻게 만들까'가 아니라, '그 기술이 인간을 어떤 존재로 만들 것인가'라고 근본적인 질문을 던지는 굉장히 의미 있는 세션이었습니다.

Human-Centered AI Transparency: Bridging the Sociotechnical Gap, Q. Vera Liao

두 번째로 인상 깊었던 세션은 베라 리아오의 'Human-Centered AI Transparency'였습니다. 리아오의 발표 주제는 최근 발표한 논문 'AI Transparency in the Age of LLMs: A Human-Centered Research Roadmap'와도 연결돼 있는데요. AI Transparency(AI 투명성)는 현재 사회적으로 가장 중요한 화두 중 하나입니다. 예를 들어 사람들은 금융, 의료, 대출 심사, 자율 주행과 같은 고위험 영역에서 AI가 내린 결정을 무조건 받아들이지 않습니다. 그 결정이 어떻게 내려졌는지, 다른 조건이었다면 결과가 달라졌을지, 오류가 발생했을 때 어떻게 수정할 수 있는지에 대한 답을 반드시 요구합니다.

리아오는 기존의 기술적 설명 가능성(AI 시스템의 의사 결정 과정을 인간이 이해하고 신뢰할 수 있도록 설명하는 기술 및 방법론) 연구의 한계를 지적했습니다. 단순히 모델의 내부 작동 원리를 나열하거나 수학적 지표를 제시하는 기존의 방식은 실제 사용자에게 거의 도움이 되지 않는다고 말했습니다. 대신 '사회기술(socio-technical)적 간극을 메우는 것'이 필요하다고 강조했습니다. AI 투명성은 기술의 관점을 넘어 사용자가 실제로 이해하고 신뢰할 수 있는 수준으로 구현되어야 한다는 것입니다.

발표에서는 AI 투명성을 달성하기 위한 구체적인 접근 방식이 소개됐습니다.

- 불확실성 커뮤니케이션: 결과가 확정적이지 않을 때 이를 숨기지 않고 명확히 전달한다.

- 반사실적 설명: 만약 조건이 달랐다면 결과가 어떻게 달라졌을지 논리적으로 추적해 보는 시나리오를 제공해 사용자의 이해를 돕는다.

- 상호작용 기반 투명성: 사용자가 피드백을 주고 모델이 이를 반영하는 구조를 통해 사용자가 단순한 소비자가 아니라 '조정자'로 자리매김할 수 있게 한다.

여기에 더해 리아오의 논문에서는 LLM 시대의 투명성이 직면한 새로운 난관들을 짚어냅니다. LLM은 능력이 예측 불가능하며, 같은 질문에 다른 답을 내놓는 불안정성도 보입니다. 학습 데이터는 방대하고 불투명하며, ‘프롬프트 엔지니어’ 같은 새로운 이해관계자까지 등장했습니다. 따라서 투명성은 단일한 정의로 변환 될 수 없고, '이해관계자와 맥락, 목표에 따라 달라져야 한다'는 점을 강조했습니다.

��특히 그동안 HCI와 AI 연구에서 도출된 기존의 교훈을 바탕으로 투명성은 '수단'이라고 이야기하며, '투명성의 목표는 모델 개선, 학습, 규제 준수, 신뢰 형성 등 다양하며, 모든 상황에 동일한 수준의 투명성이 필요한 것은 아니다'라고 말했습니다. 즉 투명성은 무조건 신뢰를 높이려는 도구가 아니라 '적절한 수준의 신뢰'를 형성하는 도구여야 한다고 강조했습니다. 투명성만 확보하고 통제 수단을 확보하지 못한다면 사용자에겐 좌절만 남기 때문에 '투명성과 통제는 반드시 함께 설계해야 한다'는 점도 중요한 메시지였습니다.

리아오는 연구자와 산업계가 지금까지 축적한 네 가지 주요 접근법을 정리했습니다.

- 모델 보고(model reporting): 모델 카드(예: Gemma 3 모델 카드)와 같은 문서화 및 데이터와 개발 배경 투명화

- 평가 결과 공유(evaluation results): 단순 성능 수치뿐 아니라 편향, 안전성, 리스크 평가 포함

- 설명 제공(explanations): 반사실적 설명, 사례 기반 설명 등 다양한 방식으로 설명

- 불확실성 커뮤니케이션(uncertainty communication): 수치만 전달하는 것이 아니라 숫자 외에 언어적·시각적으로 보다 다양하고 풍부한 표현 수단을 활용

상호 보완적으로 작동하는 이 네 가지 접근법은 모두 인간 중심적 설계가 핵심입니다. 리아오는 발표에서 'AI가 신뢰받기 위해 필요한 것은 단순히 높은 성능이 아니라, 사용자가 납득할 수 있는 설명 가능성'이라는 것을 여러 번 강조했습니다. 실제로 발표 직후 연구자들��이 '자신의 시스템에 어떻게 반영할 수 있을까' 혹은 '설명 가능한 것이 정말 유의미할까'를 두고 활발히 토론하기도 했습니다. 관련 규제가 신설되는 등 빠르게 법제화가 진행되는 현 상황에서 리아오의 제안은 실질적으로 도움을 줄 수 있는 제안이었습니다.

결국 리아오의 메시지는 투명성은 단순히 모델 내부를 열어보는 것에서 그치면 안 되고 사람들의 목표와 인지적 한계, 사회적 맥락을 고려해 설계하는 것까지 나아가야 한다는 의미였습니다. 또한 때로는 투명성만으로 충분하지 않으며, 책임과 이를 뒷받침하는 제도적 장치가 함께 마련될 때 비로소 인간 중심의 AI가 가능하다는 것입니다. 저 또한 업무에서 여러 가지 AI 전문가 시스템을 제작하면서 추상적으로 느끼고 있던 부분이었는데요. 이를 명확하게 인지할 수 있게 돼 매우 인상 깊었던 세션이었습니다.

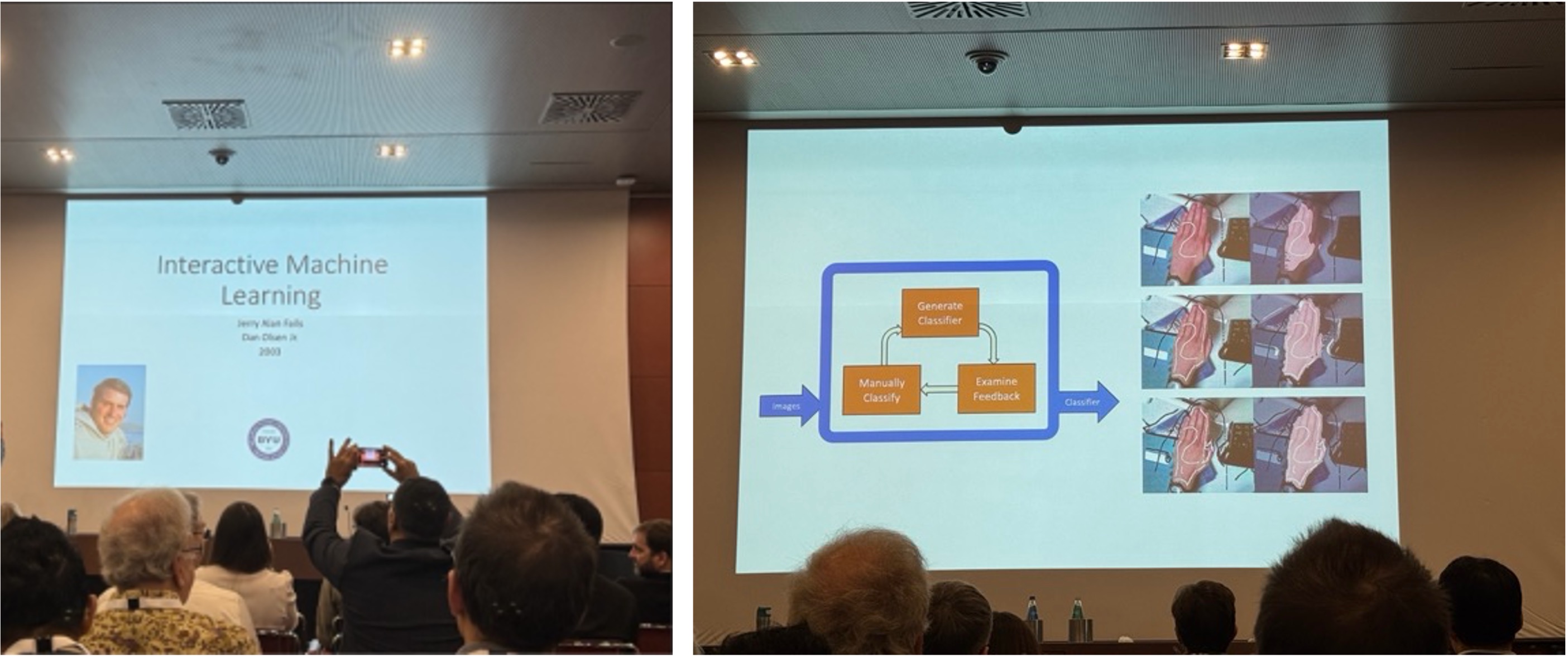

Interactive Machine Learning, Jerry Alan Fails

세 번째는 제리 앨런 페일스 교수의 세션이었습니다.

발표 자료: https://giove.isti.cnr.it/iui25-keynotes/Jerry_Fails_keynote.pdf

페일스 교수는 2003년에 발표한 Interactive Machine Learning(이하 IML) 논문으로 IUI 2025에서 'Impactful Paper Award'를 수상했습니다. 발표 후 오랜 시간이 지났음에도 이 논문이 여전히 영향력이 있다고 인정받은 이유는 이 논문에 담긴 아이디어가 지금의 연구 흐름과 맞닿아 있기 때문입니다.

페일스 교수의 논문은 당시 전통적인 머신러닝의 한계를 지적하며 사용자가 학습 과정에 직접 개입하는 방식을 제안했습니다. 기존의 모델은 정해진 데이터로 학습한 뒤 결과만을 내놓았습니다. 하지만 페일스 교수는 사용자가 모델의 분류 결과를 확인하고, 잘못된 부분을 수정하며, 그 수정이 다시 모델 학습에 반영되는 인터랙티브 루프를 설계했습니다. 그는 이를 통해 머신러닝이 단순한 자동화 도구가 아니라 사용자와 함께 성장하는 도구가 될 수 있음을 보여줬습니다. 오늘날에는 'Human-in-the-Loop'라는 개념으로 널리 알려져 있지만, 당시에는 매우 혁신적인 접근이었습니다.

이번 발표에서 그는 IML이 단순히 과거의 아이디어가 아니라 현재에도 활발히 인용되고 응용되고 있음을 강조했습니다. 교육 도구에서는 학생들이 직접 데이터를 조작하며 모델을 학습시키는 방식으로 활용되고 있고, 사용자 중심 인터페이스 디자인에서는 AI가 사용자 행동에 맞게 적응하는 구조로 이어지고 있습니다. 또 연구 지원 도구에서는 대규모 데이터 분석에 사용자의 피드백을 포함시키는 방법론으로 IML 개념이 활용되고 있습니다.

발표를 들으며 2003년에 발표된 논문이 시대를 관통해 현재의 연구와 실무에 연결돼 있다는 점이 굉장히 인상 깊었습니다. '좋은 AI란 독립적으로 뛰어난 성능을 내는 것이 아니라 사용자와 상호작용하며 성장하는 AI다'라는 메시지는 오늘날 사람 중��심의 AI가 강조되는 맥락과 일치한다고 생각했습니다.

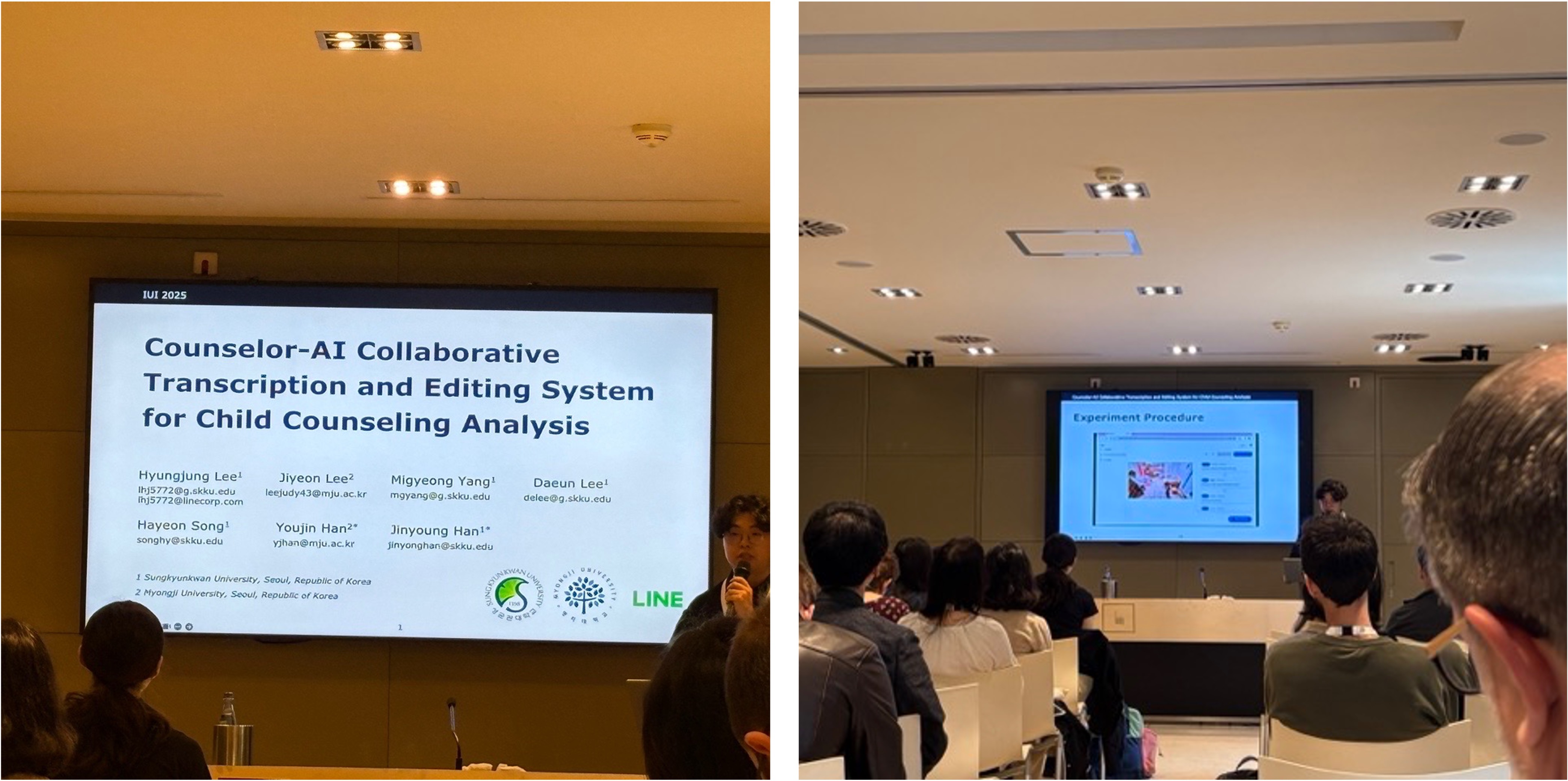

Counselor-AI Collaborative Transcription and Editing System for Child Counseling Analysis, 이형중

저는 이번 IUI 2025에서 Counselor-AI Collaborative Transcription and Editing System for Child Counseling Analysis라는 논문을 발표했습니다. 이 연구는 성균관대학교 DSAIL과 명지대학교 한유진 교수 연구실의 협업으로 진행됐고, LINE Plus의 지원을 받아 발표됐습니다.

연구의 내용은 아동 상담 현장에서 상담자가 직면하는 축어록(상담이나 대화에서 발생한 모든 언어적·비언어적 표현을 문자로 기록한 문서) 작성의 어려움을 해결하기 위한 시스템입니다. 아동 상담에서는 성인 상담과 달리 언어적 발화뿐 아니라 표정, 몸짓, 행동 같은 비언어적 단서가 매우 중요합니다. 따라서 상담자는 세세한 비언어적 단서와 그 맥락까지 기록해야 하기 때문에 이 과정에 매우 많은 시간이 소요돼 한 시간 상담을 전사하는 데 세 시간에서 여덟 시간 이상 걸리기도 합니다.

제가 제안한 시스템은 AI 기반 자동 축어록 모델과 상담자용 편집 대시보드로 구성됩니다. 자동 축어록 모델은 아동과 상담자의 발화를 구분하고, 비언어적 표현을 영상으로부터 추출해 기록합니다. 상담자는 이 자동 축어록를 기반으로 대시보드에서 결과를 검토하고 수정할 수 있습니다. AI는 객관적이고 빠른 기록을 제공하고, 상담자는 맥락과 의미를 반영해 보완함으로써 협력적 분석이 가능해집니다. 48명의 아동 상담 전문가를 대상으로 한 실험에서 93.75%가 이 시스템을 지속적으로 사용하고 싶다고 응답해 실제 상담 현장에서 업무 부담을 줄이고 상담 분석의 품질을 높일 수 있음을 확인했습니다.

이번 연구에서 특히 주목할 만한 점은, AI가 제공하는 객관적 기록과 상담자의 맥락적 해석이 상호 보완적으로 작동할 때 상담 분석의 정확성 향상뿐 아니라 상담자의 전문성 발달과 자기 성찰에도 기여할 수 있다는 것을 볼 수 있었다는 점입니다. 이 연구는 슈미트 교수가 말한 인간 능력 확장, 리아오가 강조한 투명성, 페일스가 보여준 상호작용적 학습과 같은 향후 AI가 나아가야 할 방향에 닿아 있습니다. 결국 이 시스템도 AI가 독립적으로 모든 것을 결정하는 것이 아니라 인간 전문가와 협력하며 맥락을 반영하는 구조를 지향하고 있기 때문입니다.

마치며

알브레히트 슈미트 교수의 리얼리티 디자인, 베라 리아오의 투명성, 제리 앨런 페일스 교수의 인터랙티브 머신러닝, 그리고 제 연구까지. 각 발표와 논문은 모두 다른 주제를 다루고 있지만 결국 같은 질문으로 수렴한다고 생각합니다.

'AI는 인간을 대체하는가, 아니면 인간을 강화하는가?'

IUI 2025에서 저는 이 질문에 대해 어느 정도 답을 얻었다고 ��생각합니다. AI는 사람과 함께 설계되고, 투명하게 설명되며, 인간의 능력과 책임을 존중하는 방향으로 발전해야 한다는 것입니다. 이와 같은 방향에서 제 연구 역시 의미를 가질 수 있어서 기쁜 시간이었습니다.

마지막으로 IUI 2025 학회가 진행됐던 칼리아리의 거리 사진을 끝으로 글을 마치겠습니다. 긴 글 읽어주셔서 감사합니다.