はじめに

みなさん、こんにちは! Actapio, inc.(LINEヤフー株式会社の100%子会社)の立��見です。

今回から始まるこの連載では、AIインフラストラクチャについて、じっくりと掘り下げていきます。全5回を予定しており、データセンターや物理サーバ、ネットワーク、設備といった物理的な設備などレイヤーの低い分野に始まり、その上で動作するミドルウェアやプラットフォームのレイヤー、さらに将来の構想をカバーする予定です。言い換えると、OSI参照モデルをお手本に、下層から順番に各レイヤーに解説していく予定です。

今回は、その第一歩として、データセンターの技術基盤に焦点を当ててご紹介していきます。

AIプラットフォーム(ACP)の概要と強化

さて、そもそもなぜ私たちはAIインフラを作っているのでしょうか? その答えは、AIプラットフォームであるACP(AI Cloud Platform)の強化のためです。このプラットフォームは社内向けに開発され、機械学習やディープラーニングを支えるマルチテナントKubernetes環境を提供しています。AIプラットフォームであるACPは、データ処理に必要なワークフローやETL(Extract, Transform, Load)処理を実行するためのTrinoやTeradata、可視化に必要なJupyter、機械学習に必要なさまざまなAPIなど、多様なアプリケーションをサポートしています。

このAIプラットフォームはコンテナ技術を活用し、また、CPUやGPUの選択が可能であるため、柔軟なリソース管理ができるように設計されています。また、Hadoopとの連携も容易に利用でき、テナント管理機能や通信セキュリティ機能を標準で利用することができます。ACPはこれら利用者のニーズを満たすために設計・構築されました。

特に、昨�今のAI/ML利用増加に伴い、利用者が自由にGPUを利用できるよう、AIプラットフォームの機能や性能の大幅な向上に取り組んでいます。この取り組みではサーバやネットワーク、データセンターなどの基盤技術だけでなく、利用者がより便利に活用できるプラットフォームの設計や実装、またこれらを支えるストレージやデータベースなどのコアテクノロジーの追求も不可欠です。本記事ではAIプラットフォームであるACPを、文字通り物理基盤から支える米国データセンターに焦点を当て、その技術基盤について詳しく解説します。

Actapioと米国データセンターについて

Actapioはアメリカでデータセンターを運営しています。(※LINEヤフーグループはこちらのポリシーを通じて、越境データの保護に努めています)

日本ではなくアメリカでデータセンターを運営しているのにはさまざまな理由があります。特に、電気代の安さはその中で大きな理由の一つとなります。電気代はデータセンター運営における主要なコストの2〜3割を占めるため、アメリカの中でも特に電気代が安価なエリアにデータセンターを建設しました。このエリアには大規模な水力発電所があるため電気代が安いのです。また、日本では電気代が上昇傾向にあることから、このような選択を行いました。

また、このエリアは夏場は高温低湿であり、冬場は寒冷のため、データセンターの冷却はDEC(Direct Evaporative Cooling, 直接蒸発式外気冷却)を採用しています。この冷却方式では電気をそれほど多く使わないため、PUE(Power Usage Effectiveness)を1.2以下に抑えることができました。言い換えると、消費電力の高く、また、冷却が必要なGPUサーバを大量に設置するのに最適なデータセンターとも言えます。

一方で、日本国内のみでデータセンターを運営する場合と比較すると、「アメリカでのデータセンター運営に関わる人件費」や「日米間の通信コスト(海底ケーブルコスト等)」などの追加コストがかかるというデメリットも存在します。また、日米間は約8000kmの距離があるため、通信遅延が発生し、素早くレスポンスを返す必要のあるサービス通信の実現は難しいのが実情です。

これらの課題に対処するため、2つの工夫を行っています。1つ目の工夫はOCP(Open Compute Project)サーバの活用です。OCPサーバを利用することで、ツールレスな作業、フロントアクセスが可能となり、すべてのサーバに対して同じ運用作業を行うことができ、サーバ運用負荷を軽減することができます。また、サーバ等機器はサーバ組み立て工場でラックに搭載し、必要な配線(UTPケーブルやDAC, 光ケーブル等)を行い、この状態のラックごとデータセンターに納品しています。このようなラック納品を活用することで、少人数でもサーバやネットワーク、データセンターを効率的に運用することができます。

2つ目の工夫はデータ解析基盤の設置利用です。データ解析基盤は比較的時間がかかる処理が多いため、リアルタイムにレスポンスを返す必要がありません。そのため、米国データセンターにはフロントエンドサービスは設置せず、データ解析基盤を集中的に設置しています。また、データ解析基盤はCPUやGPUなどを数多く利用するため、消費電力の高いサーバ�が必要になります。そのため、電気代が安いアメリカのデータセンターに設置するのは理にかなっていると考えています。

このように、Actapioのデータセンターは日本に比べて安価な電気代を利用しながら、少人数でもサーバ・ネットワーク・データセンターを運用できるように工夫しています。これにより、コストを最小限に抑えつつ、高度なAIインフラを提供することが可能となっています。Actapioのアメリカデータセンターについては過去には JANOGで発表した紹介 もありますので、興味のある方はぜひご覧ください。

上記に加え、アメリカに拠点を持つことで、ハイパースケーラーの知見をいち早くキャッチし、それらを素早く自社のインフラに活かすことができるのも大きなメリットとなります。例えば、最近JANOG54で紹介した LLMと水冷技術への挑戦 など、情報収集だけでなく、自社データセンター内で実際に検証作業を行っています。

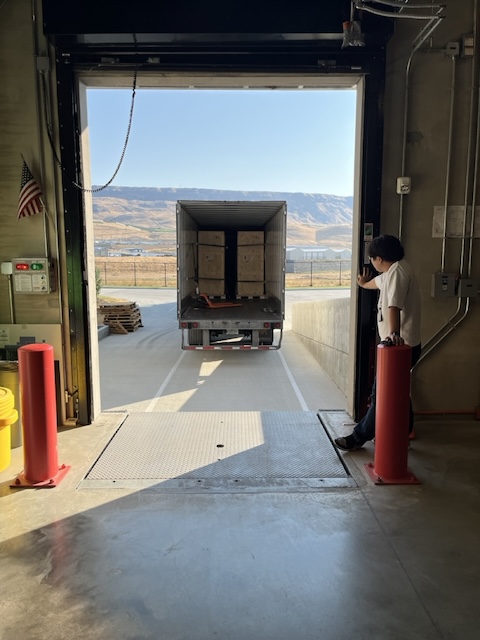

ラック納品の様子

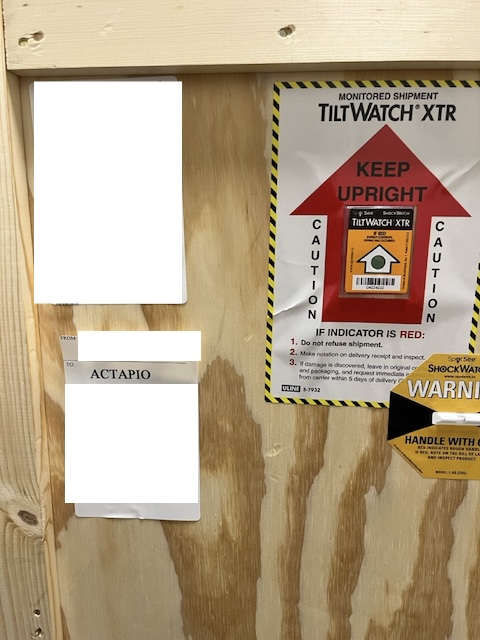

Actapioでは、ごく少数の限られた人数で、大量のサーバをスケジュール通りに、そして品質を確保して稼働させるために、サーバは工場でラックに搭載し、この状態のラックごと納品しています。ラック納品は大型トレーラーで配送されるため、サーバをフル搭載したラックを一度に数十ラック受領することができます。また、各ラックは木箱(クレート)に入れられた状態で納品され、1〜2人で簡単にラックを取り出し、データホールに設置できるようになっています。大型トレーラーでの配送と聞くと、配送時の振動により、気づかないうちにサーバ機器が故障してしまうのでは、と心配になるかもしれません。しかし木箱(クレート)にはショックインジケーターが付属しているため、万が一大きな振動により機器が故障した際にはすぐに気付けるようになっています。その後、電源やネットワークの上流接続を行うだけですぐにサーバを利用することができます。

このように、ラック納品の利点は構築プロセスを大幅に効率化できる点にあります。サーバやネットワーク機器があらかじめラックに取り付けられているため、データセンターに到着次第、迅速に設置作業を開始できます。特に、GPUサーバの重量は非常に重いため、少人数でのラッキングは困難となります。そのため、データセンター内でのラッキング作業が不要なラック納品のメリットが最大限生かされました。これにより、サーバ運用開始までの時間を短縮し、構築・運用リソースの無駄を最小限に抑えることができます。

AIインフラ用サーバの物理NW構成

データセンターの物理ネットワーク構成については、サービス通信用に100Gbpsのネットワークを冗長して使用しています。このネットワークは、Hadoopなど他のサービスも利用するClosネットワークに接続され、サービス間の連携を行うために利用されます。一方で、GPUサーバ間の通信には400Gbpsのネットワークを複数用い、RoCEv2を使用した閉じたClosネットワーク構成を採用しています。具体的にはLeaf, Spine, Super Spineの3層Closネットワークを構成し、ラック2列を一つのClosネットワーク単位とし、LeafとSpineを一つのラック(End of Rowラック)に収容しています。また将来的なGPUクラスタの拡張を考慮し、Super SpineはMDF室に設置しました。

このネットワーク構成により、高速かつ安定したデータ転送が可能となり、AIモデルのトレーニングや推論において必要なパフォーマンスを確保しています。特に、RoCEv2(RDMA over Converged Ethernet)を活用することで、低遅延かつ高スループットの通信を実現し、GPUサーバ間の効率的なデータ交換・処理を可能にしています。

ラックデザイン

サーバラックを設置する際には、ラックの物理設置や消費電力、排熱を考慮する必要があります。特に今回のAIインフラ用のGPUサーバは排熱や複数GPUサーバ間の相互接続(GPUクラスタとしての利用)を考慮し、GPUサーバを2列のラック列に固めて配置しました。GPUサーバは排熱のための冷却ファンの風圧が非常に強く、ホットアイルを挟んだ反対側にGPUサーバ以外を設置してしまうと、反対側のサーバを適切な温度に冷やせないリスクが発生してしまいます。そのため、今回のAIインフラ用GPUサーバについては、GPUサーバラック同士を向き合う位置に配置し、GPUサーバ同士の風圧を相殺して熱をホットアイル上部に逃がす工夫をしています。これにより、GPUサーバの排熱が、風量の少ない他の種類のサーバのパフォーマンスに影響を及ぼさないようにしています。

ケーブリングデザイン

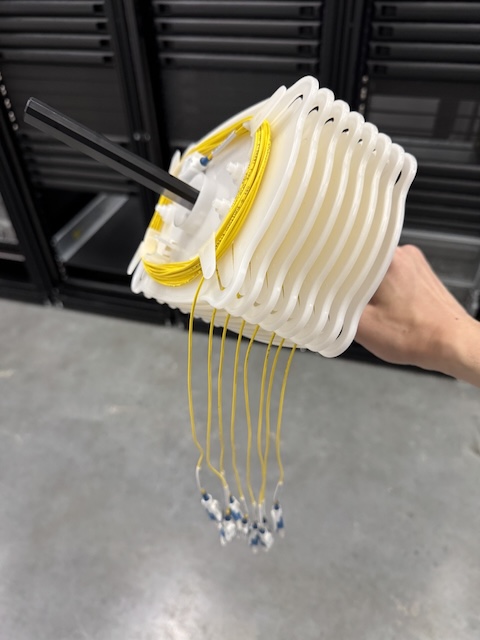

GPUサーバ間を400Gbpsで相互接続するトポロジを採用しました。実際のデータセンター内での物理配線作業のしやすさ、調達費用、部材管理といった観点も加味し、400G FR4 をはじめとした規格を中心に使用しています。また、�配線量を減らすためにEnd of Rowラックをサーバ列の中央に設置し、それぞれのGPUサーバまでの配線長を短くすることで、無駄な配線長や作業工数を減らす工夫をしています。合わせて、配線作業の工数を減らすためにケーブリングツールを活用しています。このようなツールを用いることで、最大15本までのケーブルをひとまとめに配線できるようになり、配線時間が50%以上改善することができました。それと同時に、配線時のケーブルの"よれ・からみ"からも解放されました。

このような工夫を積み重ねることで、配線作業効率を向上させ、配線時のトラブルシューティングも容易になります。

構築・運用を行って見えてきた課題

これまで述べてきたように、データセンター内でのGPUクラスタの物理設計における困難を想定し、事前に多くの工夫を行ってきました。しかし、実際に構築作業や運用作業を行うとさまざまな課題が見えてくるものです。ここではその課題の一部を紹介します。一つ目は「ケーブルの太さと配線しにくさ」、二つ目は「GPUサーバの騒音問題」、三つ目は「SFP の interoperability」です。

ケーブルの太さと配線しにくさ

GPUサーバ間で利用するMPOケーブルは太く配線しにくい点が挙げられます。ケーブルの太さだけで課題になるのか? と疑問に感じる方もいるかもしれません。しかし、少人数で数多くの配線作業を行う必要があるため、少しの工数(作業しにくさ)が積み重なることで、全体への作業影響が出てきます。このため、今後は可能な限り光ファイバーの芯数が少なく外径が細いケーブルを利用し、よりスムーズな配線作業を行いたいと考えています。

GPUサーバの騒音問題

GPUサーバの騒音は非常に大きく、サーバラック前面側で90dB(騒々しい工場と同等レベル)、背面側では100dB(電車が通る時のガード下と同等レベル)を超えることもあります。この問題は事前に分かっていたものですが、実際に目の当たりにすると圧倒される音量でした。音量が大きいと作業者への人体影響(耳)があり、これは保護しなければなりません。そのため、作業する際は耳栓やイヤーマフを使用して耳を保護するようメンバーに周知し、加えて、騒音警告ステッカーをデータホールの扉に設置しています。

SFP の interoperability

ネットワーク物理設計段階において、どのSFPを利用するかを決める必要がありました。そのため、さまざまなSFP(QSFPやOSFP, SR/FR/DRなど)を実際に6種類ほど購入し、interoperability(相互運用性)の確認を行いました。その中で、特定のNICにはOSFPではなくOSFP-RHSにしか装着できない、特定のSFP同士ではネットワークがlink upしないなどのさまざまな問題にも気づくことができました。カタログスペックだけを信用するのではなく、実際の"モノ"を用いて、素早く相互運用性の確認作業を行うことが重要である点に改めて気付かされました��。

私たちはこれらの課題を一つ一つ解決していく中で、データセンター運用やAIインフラ運用における新たな知見を得ることができました。今後の設計や運用において、これらの経験を活かしつつ、文字通り最前線で工夫や課題解決を行い、より効率的で安全な環境を提供していきたいと考えています。

最後に

本記事ではAIインフラ実現に向けて、自社のアメリカのデータセンターを用いたレイヤーの低い技術(データセンターや物理サーバ、ネットワーク、設備等)について解説しました。自社のデータセンターを持ち、自分たちで検証・構築・運用などに取り組み、その中でさまざまな工夫を行っていることが伝わったら良いなと思っています。

次回はネットワークについてさらに詳しく解説します。この連載を通じて、AIインフラの各領域におけるエンジニアが相互に連携し、それぞれの領域を学びながら取り組んでいることをお伝えしたいと思います。各領域のエンジニアがどのように協力し合い、技術的な課題を克服しているのか、そのプロセスを皆さんと共有できればと考えています。

ぜひ次回もお楽しみにしてください。